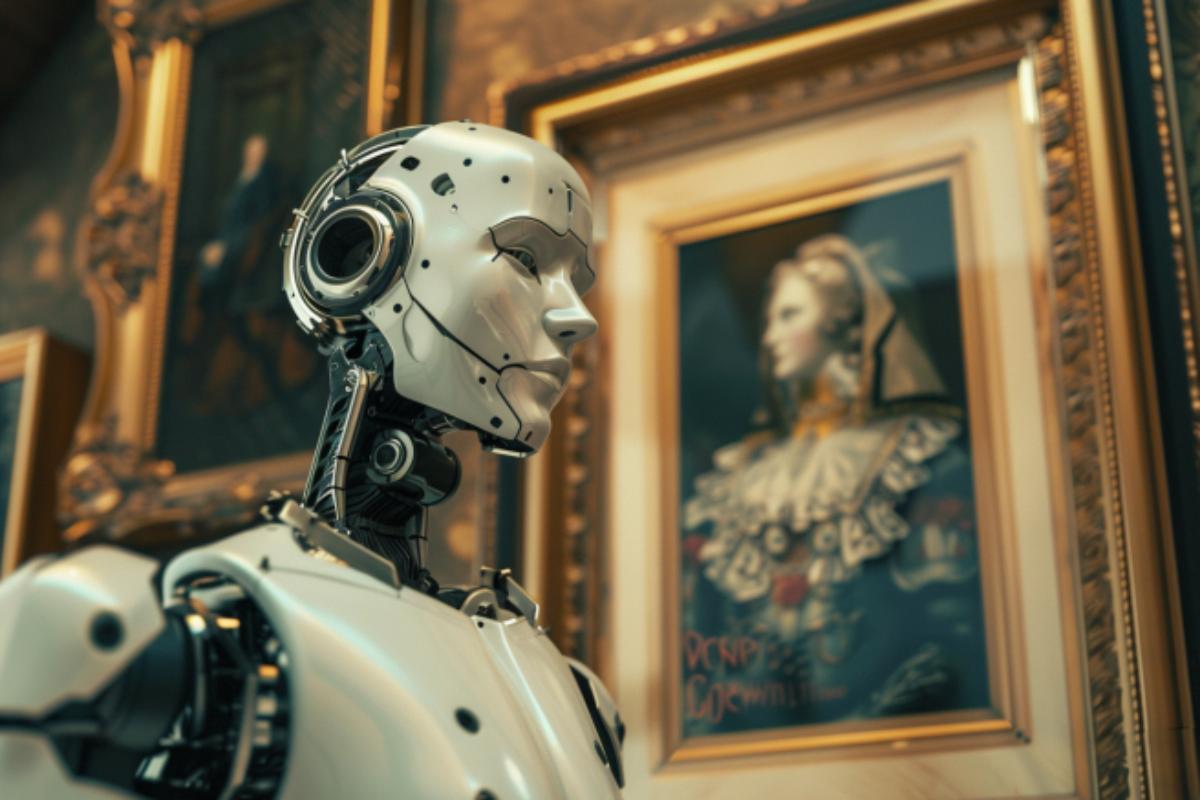

Цифровой мир без женщин: как визуальные стереотипы вредят развитию ИИ

Машинное обучение на «гендерно-перекошенных» данных ставит под вопрос инклюзивность нейросетей. Международная группа исследователей проанализировала более миллиона изображений из Google, Wikipedia и IMDb по гендерным ассоциациям в 3495 категориях, и обнаружила значительную недопредставленность женщин на этих изображениях.

Исследование, возглавляемое специалистами из Школы бизнеса Хааса при Калифорнийском университете в Беркли, также включало анализ миллиардов слов с этих платформ. Результаты показали, что гендерные предвзятости гораздо чаще встречаются на изображениях, чем в тексте, для категорий, традиционно ассоциируемых как с женщинами, так и с мужчинами.

По мнению авторов исследования, опубликованного в научном журнале Nature, с учётом того, что люди тратят всё меньше времени на чтение и всё больше времени на просмотр изображений в Интернете, это значительно усугубляет гендерные предвзятости, увеличивая их распространённость и психологическое воздействие.

Исследователи также отметили, что полученная ими статистика недопредставленности женщин намного серьёзнее и глубже, чем это фиксировалось ранее в опросах общественного мнения и прочих источниках.

Специалисты предупреждают, что модели генеративного искусственного интеллекта, обученные на огромном количестве «гендерно-перекошенных» изображений, способны дополнительно закреплять гендерные, расовые и другие социальные стереотипы.

«Устранение социальных последствий этого масштабного перехода к визуальной коммуникации будет иметь важное значение для развития справедливого и инклюзивного будущего Интернета», — отметили авторы исследования.